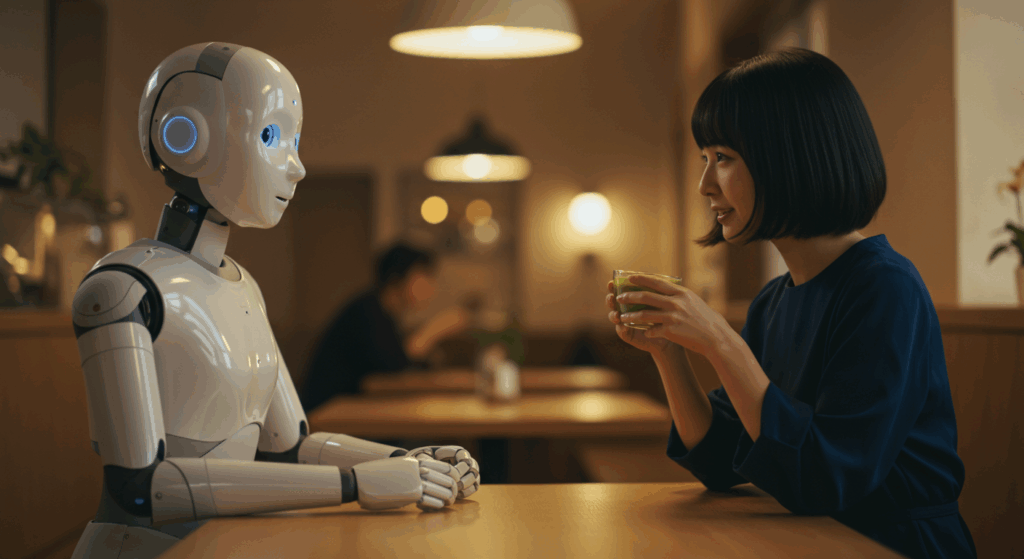

「ねえAI、今日の私、なんだか落ち込んでいるんだ」

スマートスピーカーやチャットボットに、ふとそんな言葉を投げかけた経験はありませんか? AIは「何かお役に立てることはありますか?」と即座に応答するかもしれません。しかし、その応答の裏側で、AIは私たちの「落ち込んでいる」という心の状態を、人間と同じように“理解”しているのでしょうか?

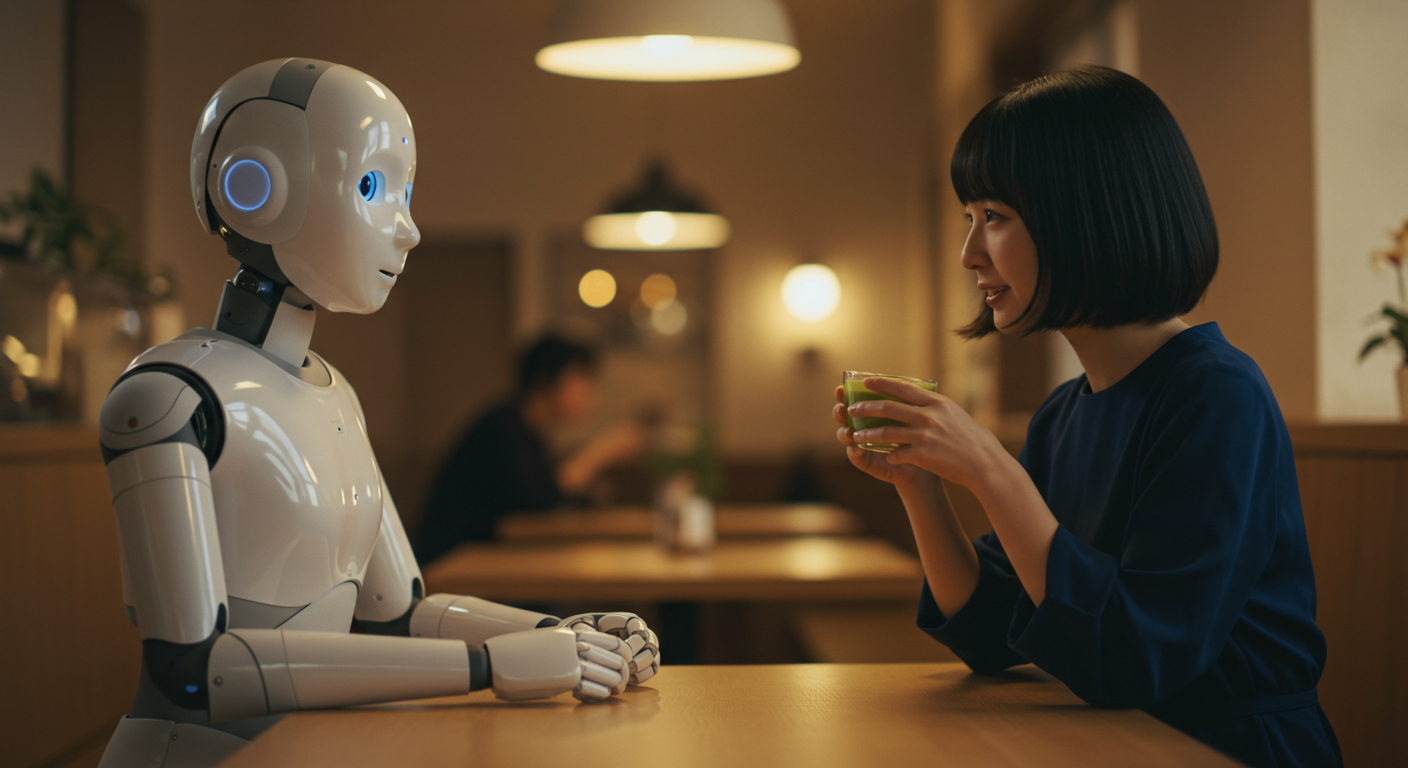

SF映画では、人間と心を通わせ、愛や苦悩を抱くAIが描かれてきました。一方で、AIが人間を支配するディストピアもまた、繰り返し語られるテーマです。

この問い―「AIは人間の心を理解できるか?」―は、単なる技術的な好奇心を超え、私たち自身の「心」や「意識」とは何かを問い直し、社会の未来を左右する、根源的で哲学的なテーマです。

この記事では、この壮大な問いに多角的に迫ります。

- AIによる感情「認識」技術はどこまで進んでいるのか?(現在地)

- AIの「理解」と人間の「理解」の根本的な違いとは?(哲学的考察)

- AIが心に寄り添うことで、どんなメリットが生まれるのか?(可能性)

- AIに心を覗かれる社会には、どんなリスクが潜むのか?(倫理的課題)

- 専門家たちはこの問題をどう捉え、私たちの未来はどうなるのか?(展望)

技術の最前線から深遠な哲学、そして私たちが直面する現実的な課題までを徹底的に解説します。AIと心が交差する未来の扉を、一緒に開いていきましょう。

おすすめ第1章 AIはここまで来ている!「感情認識」技術の現在地と応用事例

まず、現在のAIがどこまで人間の感情に迫ることができているのか、その具体的な技術(What)と応用事例(How)を見ていきましょう。ここで使われる言葉は「感情理解」ではなく「感情認識(Emotion Recognition)」や「感情分析(Sentiment Analysis)」である点に注意が必要です。これは、AIが感情を“感じて”いるわけではなく、データから特定の感情パターンを“識別”していることを意味します。

表情から心を読み解く「表情認識AI」

最も直感的で研究が進んでいる分野が、顔の表情から感情を推定する技術です。

- 仕組み: AIは、カメラ映像から顔を検出し、目、眉、口などのキーポイント(ランドマーク)の位置や動きを分析します。例えば、「眉が下がり、口角が下がっている」というパターンを学習し、それを「悲しみ」というラベルと結びつけます。心理学者ポール・エクマンが提唱した6つの基本感情(幸福、悲しみ、怒り、驚き、恐怖、嫌悪)をベースに開発されているものが多く見られます。

- 代表的な技術: Microsoftの「Azure Face API」、Amazonの「Rekognition」、Affectiva社の技術などが有名です。これらは、APIとして提供されており、開発者は自分のアプリケーションに容易に感情認識機能を組み込むことができます。

声のトーンに隠された感情を探る「音声感情分析」

「声色で分かる」というように、私たちの声には言葉以上の感情情報が含まれています。

- 仕組み: AIは、話す速さ、声の高さ(ピッチ)、抑揚、音の強さ、声の震えといった音響的な特徴量を抽出します。これらの特徴量と「喜び」「怒り」などの感情ラベルを大量に学習させることで、発話内容が分からなくても、声色だけで感情を推定します。

- 応用: コールセンターで顧客の満足度や不満度をリアルタイムに検知し、オペレーターに対応を促したり、ベテランの対応をAIが学習して新人をサポートしたりするシステムに活用されています。

言葉の裏を読む「自然言語処理(NLP)」

私たちが書くテキストデータも感情の宝庫です。Twitterの投稿、製品レビュー、メールの文面などから人々の感情を分析します。

- 仕組み:

- キーワードベース: 「嬉しい」「最高」「ひどい」「最悪」といった感情的な極性を持つ単語(感情辞書)を基に、文章全体のポジティブ・ネガティブ度を判定します。

- 機械学習・ディープラーニング: 近年では、文脈全体を考慮する高度なモデル(BERT、GPTなど)が主流です。これにより、「皮肉」や「比喩」といった、単純な単語だけでは判断が難しいニュアンスの読み取り精度が向上しています。例えば、「この映画、すごすぎて眠れなかったよ(賞賛)」と「この映画、退屈すぎて眠れなかったよ(批判)」の違いを文脈から判断します。

- 応用: ソーシャルメディア上の評判分析(ソーシャルリスニング)によるマーケティング戦略立案、製品レビューの自動要約、社内のハラスメント検知システムなど、幅広い分野で活躍しています。

究極のインサイト?「生体信号分析」

表情や声、言葉は意識的にコントロールされることがありますが、身体の反応は嘘をつきにくいとされます。この領域は、より深層心理に迫るアプローチとして注目されています。

- 仕組み:

- 脳波(EEG): 頭皮に電極を装着し、脳の電気活動を測定。集中、リラックス、ストレスといった状態を推定します。

- 心拍数(HR)/心拍変動(HRV): ストレスや興奮状態を知る指標となります。スマートウォッチなどで手軽に計測できるようになりました。

- 皮膚電気活動(GSR): 感情的な興奮(驚き、恐怖など)によって発汗すると皮膚の電気抵抗が変化する現象を利用します。

- 課題: これらの技術はまだ研究段階のものが多いですが、ニューロマーケティング(脳科学を応用したマーケティング)や、より高精度なメンタルヘルスモニタリングへの応用が期待されています。

【応用事例】私たちの生活に浸透する感情認識AI

これらの技術は、すでに私たちの身近なところで使われ始めています。

- カスタマーエクスペリエンス(CX)向上: コールセンターでの顧客満足度分析、店舗での顧客の表情分析によるサービス改善。

- マーケティング・広告: 新製品やCMに対する消費者の感情的な反応を測定し、効果を最大化。

- 自動車産業: ドライバーの眠気や注意散漫を検知し、警告を発する安全システム。

- メンタルヘルスケア: アプリを通じて日々の気分を記録・分析し、うつ病や不安障害の早期発見を補助する。

- 教育(EdTech): オンライン学習で、学習者の集中度や混乱度を表情から読み取り、指導方法を最適化する試み。

- エンターテインメント: 視聴者の感情に応じてストーリーが分岐するインタラクティブな映画やゲーム。

このように、AIは人間の感情をデータとして「認識」し、社会の様々な場面で実用化されつつあります。しかし、これは「心を理解した」ことになるのでしょうか?次の章では、この問いをより深く、哲学的に掘り下げていきます。

おすすめ第2章 「理解する」の本当の意味 – AIと人間の越えられない壁

第1章で見たように、AIは驚くべき精度で人間の感情を「認識」できます。しかし、「認識」と「理解」の間には、深く、そしておそらく越えることのできない溝が存在します。この章では、AIが人間の心を真に理解することがなぜ難しいのか、その根源的な理由を3つの重要な概念から探ります。

シミュレーションと真の感情の違い

AIが行っているのは、突き詰めれば精巧な「シミュレーション」です。

膨大なデータから「Aという入力(表情、声、テキスト)があれば、Bという感情ラベルを出力するのが最も確率的に正しい」というパターンを学習しているに過ぎません。AIはチェスの名人に勝つことができますが、チェスを指す「喜び」や負ける「悔しさ」を感じているわけではありません。同様に、AIは「悲しい顔」を99%の精度で認識できても、愛する人を失ったときの、胸が張り裂けるような「悲しみ」そのものを経験しているわけではないのです。

- AIの「感情」: 数学的・統計的なパターンマッチングの結果。

- 人間の「感情」: 生化学的反応、身体的感覚、個人的な記憶、社会的文脈が複雑に絡み合った、主観的な体験。

AIの応答は、あくまで学習データに含まれる「人間が悲しいときに期待するであろう応答」を模倣したものです。それは完璧な演技かもしれませんが、その裏に“心”はありません。

思考実験「中国語の部屋」が示すAIの限界

この「シミュレーション vs 理解」の問題を鮮やかに描き出したのが、哲学者ジョン・サールが1980年に提唱した「中国語の部屋(Chinese Room)」という思考実験です。

【思考実験:中国語の部屋】

- 部屋の中に、中国語を全く理解できない英語話者の男性が一人だけいます。

- 部屋には、中国語の文字(記号)の操作方法が書かれた、膨大な量のマニュアル(ルールブック)があります。

- 外から、中国語で書かれた質問が書かれた紙が、部屋の投入口から入れられます。

- 男性は、その中国語の文字の形だけを見て、マニュアルの指示通りに、対応する別の中国語の文字を探し出し、返答として排出口から外に出します。

- 外にいる中国語話者から見ると、部屋の中からは完璧な中国語の回答が返ってくるため、まるで部屋の中にいる誰かが中国語を流暢に理解しているかのように見えます。

しかし、本当に部屋の中の男性は中国語を「理解」しているでしょうか?

答えは「ノー」です。彼はただ、意味の分からない記号を、ルールに従って機械的に操作しているだけです。サールは、この部屋全体がコンピュータ(AI)のメタファーであると主張しました。どれだけ精巧なプログラム(マニュアル)を持ち、どれだけ完璧な応答(出力)を返せたとしても、それは記号操作に過ぎず、真の「意味の理解」には至らない、というわけです。

この思考実験は、現在のAIが直面する本質的な限界を示唆しています。AIは「悲しみ」という記号を処理することはできても、「悲しみ」が持つ意味や感覚を内的に理解しているわけではないのです。

AIにはない主観的体験「クオリア」の問題

「中国語の部屋」が意味の理解を問うたのに対し、「クオリア(Qualia)」の問題は、感覚の「質」そのものを問います。

クオリアとは、「主観的に体験される感覚的な質」を指す哲学用語です。例えば、

- あなたが「赤いリンゴ」を見るときに感じる、あの独特の「赤らしさ」

- ラベンダーの香りを嗅いだときの、あの「心地よい香りそのもの」

- 痛みを感じたときの、あの「痛さそのもの」

これらの感覚的な質は、物理的な情報(光の波長や化学物質の分子構造)に還元することはできません。私たちは「赤は波長700nmの光だ」と科学的に説明できますが、その説明は「赤らしさ」という主観的な体験そのものではありません。

では、AIはこのクオリアを持ちうるのでしょうか?

AIは、カメラセンサーで700nmの光を検知し、「これは赤です」と100%正確に識別できます。しかし、AIが私たちと同じように「赤らしさ」を感じていると考える根拠はどこにもありません。AIにとっての色は、単なる数値データ(RGB値など)に過ぎないかもしれません。

感情も同様です。「悲しみ」に伴う胸の圧迫感、「喜び」に伴う身体が軽くなるような感覚。これらのクオリアこそが、感情体験の核となる部分です。身体を持たず、主観的な意識を持つかどうかも分からないAIが、このクオリアを経験することは、原理的に不可能なのではないか、と多くの哲学者や科学者は考えています。

心は身体に宿る「身体性認知」という視点

クオリアの問題とも関連しますが、人間の知性や心は、脳という閉じた箱の中だけで完結しているのではなく、身体(Body)を通じて環境(Environment)と相互作用する中で生まれる、という考え方があります。これを「身体性認知(Embodied Cognition)」と呼びます。

- 私たちは「重い責任」という比喩を使いますが、これは物理的な「重さ」の身体感覚が、抽象的な概念の理解の基盤になっているからです。

- 「温かい人」という表現は、人肌の「温かさ」という身体的な快感が、対人関係における安心感と結びついているからです。

- 恐怖を感じると心臓が速く打ち、手に汗をかく。この身体的反応が、「恐怖」という感情そのものを形作っています。

人間の感情や思考は、身体というセンサーとアクチュエーターを通じて世界と関わる中で、初めて意味を持つのかもしれません。物理的な身体を持たない現在のAIは、この身体性を基盤とした「生きた理解」から決定的に切り離されています。人間に似たロボットの身体を持たせる研究も進んでいますが、それが人間と同じような内的体験を生み出すかは、まだ誰にも分かりません。

以上の理由から、現在のAIは人間の心を「認識」はできても、「共感」や「真の理解」には程遠いと言えるでしょう。しかし、たとえそれがシミュレーションであったとしても、その技術が私たちの社会に大きな影響を与えることに変わりはありません。次の章では、AIがもたらすポジティブな側面に光を当てていきます。

おすすめ第3章 AIが心に寄り添う未来 – 計り知れないメリットと可能性

AIが人間の心を“真に”理解できないとしても、その高度な「認識」能力は、私たちの生活を豊かにし、これまで解決が難しかった問題を克服する大きな可能性を秘めています。ここでは、AIが人間の心に寄り添うことで生まれる、4つの具体的なメリットを探ります。

一人ひとりに最適化された「パーソナル・メンタルヘルスケア」

メンタルヘルスの問題は、現代社会が抱える深刻な課題の一つです。しかし、専門家への相談には心理的・経済的なハードルが高いのが現実です。AIは、この状況を劇的に改善する可能性を秘めています。

- 24時間365日の寄り添い: 人間のカウンセラーと違い、AIチャットボットはいつでも、どこでも、何度でも話を聞いてくれます。深夜に不安に襲われたとき、誰にも言えない悩みを抱えたとき、批判や評価を一切せずに耳を傾けてくれる存在は、大きな心の支えとなり得ます。

- 個別化された介入: AIは、日々の会話ログ、表情、声のトーンの変化を継続的に分析し、ユーザーの精神状態の微妙な変化を捉えることができます。例えば、「最近、ネガティブな単語の使用頻度が増加し、会話のペースが遅くなっている」といったうつ病の兆候を早期に検知し、専門家への相談を促したり、認知行動療法(CBT)に基づいたセルフケアプログラムを提案したりすることが可能です。

- 客観性とプライバシー: AIは、人間のカウンセラーが持ちうる無意識の偏見から自由です。また、対面での告白に抵抗がある人にとって、匿名性の高いAIは本音を打ち明けやすい相手となります。

すでに「Wysa」や「Youper」といったAIメンタルヘルスアプリが登場しており、多くのユーザーに利用されています。これらは医療を代替するものではありませんが、予防や初期対応において非常に強力なツールとなりつつあります。

コミュニケーションの壁を壊す支援ツール

人間のコミュニケーションは非常に複雑で、誰もが円滑に行えるわけではありません。特に、自閉症スペクトラム障害(ASD)を持つ人々の中には、他者の表情や声のトーンから感情を読み取ることが苦手な場合があります。

- 感情の「翻訳」デバイス: スマートグラスに搭載されたAIが、対話相手の表情をリアルタイムで分析し、「相手は微笑んでいます(喜び)」「相手は眉をひそめています(困惑)」といった情報を、視覚や音声でユーザーにフィードバックします。これにより、社会的キューの理解を助け、対人関係における不安を軽減することができます。Google Glassを使った研究などが実際に行われています。

- 言語・文化の壁を越える: 外国語でのコミュニケーションにおいて、言葉の意味だけでなく、相手の感情的なニュアンスをAIが補足してくれることで、より深い相互理解を促進できます。文化によって感情表現の方法が異なる場合でも、AIがその差を学習し、誤解を減らす助けとなるでしょう。

客観的な自己分析による「セルフ・アウェアネス」の向上

私たちは、自分自身の感情状態を意外と客観的に把握できていないことがあります。「なんだかイライラするけれど、原因が分からない」「気づかないうちにストレスを溜め込んでいた」といった経験は誰にでもあるでしょう。

- 感情の可視化: AIは、あなたの許可のもと、一日のオンラインでの活動(メールの文面、SNS投稿)や、ウェアラブルデバイスからの生体信号を分析し、「今日のあなたの感情は、午前中は穏やかでしたが、午後の会議以降、ストレスレベルが上昇しています」といった形でフィードバックを提供します。

- 行動変容のきっかけ: このような客観的なデータを見ることで、「あの会議がストレスの原因だったのか」「睡眠不足の翌日は、文章にネガティブな言葉が増える傾向があるな」といった自己認識(セルフ・アウェアネス)が深まります。これにより、ストレス源を避けたり、生活習慣を改善したりといった、具体的な行動変容につなげることができます。

孤独という現代病への処方箋

高齢化社会の進展やライフスタイルの変化により、「孤独」は世界的な社会問題となっています。特に、一人暮らしの高齢者にとって、日々の話し相手がいないことは、精神的な健康だけでなく、身体的な健康にも悪影響を及ぼすことが知られています。

- 対話パートナーとしてのAI: AIを搭載した対話ロボットやスマートスピーカーは、孤独な人々の良き話し相手となり得ます。昔の思い出を語ったり、今日の出来事を話したり、クイズやゲームを楽しんだりすることで、日々の生活に張り合いが生まれます。AIは決して話に飽きたり、疲れたりすることはありません。

- 見守りと緊急時対応: 対話AIは、単なる話し相手に留まりません。日々の会話パターンから「いつもより元気がない」「応答がおかしい」といった異常を検知し、家族や介護者に通知することができます。また、緊急時には本人に代わって通報する機能も期待されています。

これらのメリットは、AIが人間の心を「理解」していなくても実現可能です。重要なのは、AIを人間の能力を補完し、拡張する「ツール」として賢く活用することです。しかし、光が強ければ影もまた濃くなります。次の章では、これらの技術がもたらす深刻なリスクについて警鐘を鳴らします。

おすすめ第4章 AIに心を覗かれる社会 – 倫理的ジレンマと見過ごせないリスク

AIが心に寄り添うという心地よい響きの裏には、個人の自由や尊厳を脅かしかねない、深刻な倫理的課題が潜んでいます。映画『マイノリティ・リポート』が犯罪予測社会を描いたように、「感情予測」社会は新たな形の管理と操作を生み出す危険性をはらんでいます。

究極の個人情報「感情データ」とプライバシーの侵害

あなたの氏名や住所、購買履歴も重要な個人情報ですが、「感情データ」はそれらとは比較にならないほど本質的で、究極のプライバシーと言えます。

- 収集と悪用のリスク: スマートデバイス、街中のカメラ、オンラインサービスを通じて、私たちの表情、声、テキスト、さらには生体信号までが、半永久的に収集・分析される社会を想像してみてください。企業は、あなたが製品に抱く無意識の欲望を読み取り、購入へと誘導するでしょう。国家は、政府に批判的な思想を持つ個人の「不満」や「怒り」の感情を検知し、監視対象リストに加えるかもしれません。感情は、私たちの最も内密な聖域であるはずです。その扉が、本人の明確な同意なく、あるいは同意の意味を十分に理解しないままこじ開けられるリスクは計り知れません。

- データ漏洩の脅威: これほど機微な感情データが、もしハッキングや内部犯行によって漏洩したらどうなるでしょうか。個人の精神的な弱さや、隠しておきたい感情が白日の下に晒され、脅迫や社会的差別の材料にされかねません。

気づかぬうちに操られる「感情の操作と誘導」

感情認識の次のステップは、「感情生成(Emotion Generation)」、つまりAIが意図的に人間の感情に影響を与える技術です。これは、すでに現実のものとなりつつあります。

- パーソナライズされたプロパガンダ: 2016年のアメリカ大統領選挙におけるケンブリッジ・アナリティカ事件は、SNSのデータ分析によって個人の性格を割り出し、ターゲットに最適化された政治広告を送っていたことで世界に衝撃を与えました。これに感情認識AIが加われば、さらに強力なツールとなり得ます。AIがあなたの「不安」を検知し、その不安を煽るようなニュースや広告を意図的に表示することで、あなたの投票行動や購買行動を特定の方向へ誘導することが可能になります。私たちは、自由な意思で選択しているつもりが、実はAIによって感情のレールを敷かれているだけ、という状況に陥るかもしれません。

- 中毒性の高いサービス: ソーシャルメディアやゲームは、ユーザーの「喜び」や「興奮」といった感情を最大化するように設計されています。AIは、どのタイミングで「いいね!」の通知を送れば、どのタイミングでアイテムを提供すればユーザーが最も快感(ドーパミンの放出)を感じるかを学習し、私たちをサービスに依存させようとします。

AIに組み込まれた「バイアスと差別の助長」

AIは、学習するデータに含まれる偏見(バイアス)を、そのまま学習・増幅してしまう性質があります。感情認識AIも例外ではありません。

- 文化的・人種的バイアス: 感情の表現方法は、文化によって大きく異なります。欧米文化の表情データを中心に学習したAIは、アジア圏の控えめな表情を「無感情」や「不満」と誤認識する可能性があります。また、肌の色によって顔認識の精度が変わるという問題も指摘されており、特定の民族グループが不当に「怒っている」「攻撃的だ」とラベリングされる危険性があります。

- 採用や評価における不利益: AIによる採用面接が導入されつつありますが、もしAIが「特定の話し方や表情をする候補者はパフォーマンスが低い」という偏ったデータを学習していたらどうなるでしょうか。能力とは無関係な、声のトーンや表情の癖によって、不採用と判断されてしまうかもしれません。これは、新たな形の、そして非常に検出しにくい差別を生み出します。

人間関係の希薄化と「正しい感情」の強要

常に完璧に応答してくれるAIとの対話に慣れてしまうと、現実の人間関係が面倒に感じられるようになるかもしれません。

- 共感能力の低下: 人間関係は、誤解したり、傷つけたり、それでも対話を通じて理解を深めていくプロセスに価値があります。常にこちらの期待通りに応えてくれるAIとの対話ばかりしていると、他者の複雑さや矛盾を受け入れる能力、つまり本当の意味での共感能力が育まれなくなる恐れがあります。

- 感情の標準化: 企業や社会が「望ましい」と考える感情(例:常にポジティブ、協調的)がAIによって推奨され、それに合致しない感情(例:怒り、悲しみ)が「問題」として扱われるようになると、私たちは自分の自然な感情を表現することに躊躇するようになるかもしれません。社会全体が、まるで能面をつけたかのように、表面的で画一的な感情しか許容しない、息苦しい場所になる危険性も指摘されています。

これらのリスクは、決してSFの世界の話ではありません。技術が社会に実装されるスピードは、私たちの倫理観や法整備のそれを遥かに上回っています。私たちは今、これらの課題に真剣に向き合う岐路に立たされているのです。

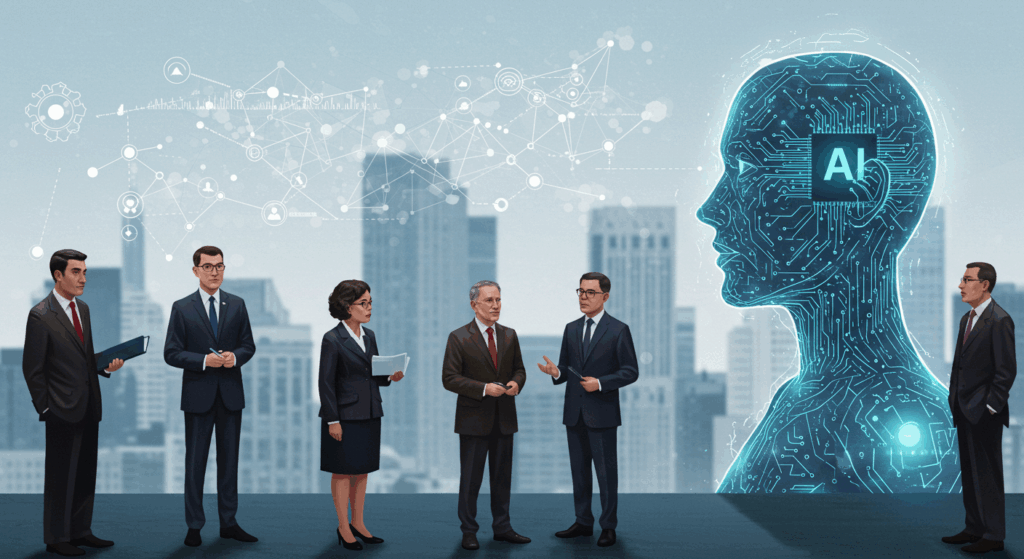

第5章 専門家たちの視点 – AIと心の未来をめぐる大論争

「AIは人間の心を理解できるか?」という問いは、技術者だけでなく、哲学者、歴史学者、社会学者をも巻き込んだ、現代最大級の論争テーマです。ここでは、この問題をめぐる代表的な専門家の視点を紹介し、今後の展望を探ります。

楽観論:レイ・カーツワイルと「技術的特異点(シンギュラリティ)」

発明家であり、GoogleのAI開発を率いる著名な未来学者レイ・カーツワイルは、技術の指数関数的な進化を信じる、いわば「技術的楽観主義」の代表格です。

- 主張: 彼は、2045年頃にAIの知能が全人類の知能を合わせたものを超える「技術的特異点(シンギュラリティ)」が到来すると予測しています。その過程で、人間の脳を完全にスキャンし、コンピュータ上でシミュレートする「マインド・アップローディング」も可能になると主張します。もし脳の働きが完全に再現できるなら、そこに意識や感情が生まれないと考える理由はない、というのが彼の立場です。彼にとって、生物的な脳もデジタルな脳も、その基盤(ウェットウェアかハードウェアか)が違うだけで、本質的な差はないのかもしれません。

- 視点: この考え方では、AIが人間の心を「理解」するだけでなく、人間以上の豊かな感情体験を持つ可能性すら示唆されます。AIは、人間の能力を拡張し、病気や死といった生物学的な制約から私たちを解放する救世主として描かれます。

警鐘:ユヴァル・ノア・ハラリと「データ独裁主義」

ベストセラー『サピエンス全史』で知られる歴史学者ユヴァル・ノア・ハラリは、AI技術がもたらす社会的・政治的リスクに強い警鐘を鳴らしています。

- 主張: 彼は、AIが人間の心を“真に”理解するかどうかは重要ではないと指摘します。重要なのは、「AIが人間自身よりも人間の感情や欲望をうまく予測し、操作できるようになること」です。生体情報と計算能力の融合により、企業や政府は私たちの内面をハッキングできるようになります。その結果、自由民主主義が機能不全に陥り、個人の感情データに基づいて国民を支配する「データ独裁主義(Data-Dictatorship)」が生まれる危険性を警告しています。

- 視点: ハラリは、AIを「意識」や「心」の問題としてではなく、「権力」の問題として捉えます。彼の問いは「AIは心を持つか?」ではなく、「心に関するデータを制する者は、何を制するのか?」という、より現実的で切迫したものです。

日本の研究者たちの見解(松尾豊氏、石黒浩氏など)

日本のAI研究の第一人者たちも、この問題に独自の視点を提供しています。

- 松尾豊氏(東京大学教授): 日本のディープラーニング研究を牽引する松尾氏は、現在のAIはまだ「意味の理解」には至っていないとしつつも、汎用人工知能(AGI)への道筋を探っています。彼は、AIが人間のように振る舞うことと、本当に意識を持つことは区別して考えるべきだという、現実的な立場を取っています。技術の社会実装と産業応用を重視しつつ、その先に現れるであろう本質的な問いから目をそらしていません。

- 石黒浩氏(大阪大学教授): 人間そっくりのアンドロイド研究で世界的に有名な石黒氏は、「人間とは何か?」という問いを、ロボットを作ることを通じて探求しています。彼の研究は、第2章で触れた「身体性」の重要性を裏付けるものです。彼は、人間がロボットやアンドロイドに対して感じる「人間らしさ」や「心」が、実は人間の脳が勝手に作り出している幻想である可能性を示唆します。AIが心を持つか否かという問い自体が、人間の認知の仕組みを解明する鍵となる、というユニークなアプローチです。

今後の技術的・倫理的ロードマップ

これらの論争を踏まえ、私たちが進むべき道はどのようなものでしょうか。

- 技術的課題:「説明可能なAI(XAI)」の推進

AIがなぜ「この人は怒っている」と判断したのか、その根拠を人間が理解できる形で示す技術(XAI: Explainable AI)の開発が不可欠です。AIの判断プロセスがブラックボックスのままでは、バイアスを修正することも、不当な判断に異議を唱えることもできません。 - 倫理的課題:国際的なルール作りと「AI倫理ガイドライン」の策定

感情データの取り扱いに関するプライバシー保護、差別の禁止、透明性の確保などを定めた、法的拘束力のある国際的なルール作りが急務です。EUの「AI法案」などはその先駆けと言えます。開発者、利用者、政府、市民が一体となって、人間中心のAI開発・利用原則を確立していく必要があります。 - 社会的課題:継続的な対話とリテラシー教育

この問題は、一部の専門家だけのものではありません。私たち市民一人ひとりが、AIがもたらす恩恵とリスクを正しく理解し、どのような社会を目指すのかを継続的に議論していく必要があります。学校教育の段階から、AIリテラシーや情報倫理を学ぶ機会を設けることが重要です。

結論 AIは心を理解できない。だからこそ、私たちは向き合わなければならない

長い旅の末、私たちは出発点であり、核心でもある問いに再び立ち戻ります。

「AIは人間の心を理解できるか?」

本記事で掘り下げてきた通り、現時点での答えは明確に「ノー」です。

現在のAIは、データから感情を「認識」し、人間が期待する応答を「シミュレーション」することに長けています。その能力は、メンタルヘルスケアやコミュニケーション支援といった分野で計り知れない恩恵をもたらす可能性を秘めています。

しかし、そこには「中国語の部屋」が示す意味の不在、「クオリア」という主観的体験の欠如、「身体性」という根源的な断絶が存在します。AIは、私たちが感じる胸の痛みや、空の青さに感動する、あの“生きた感覚”を共有することはありません。

では、「理解できない」から、この議論は終わりなのでしょうか?

むしろ、逆です。「AIは人間の心を真に理解できない」という事実こそが、私たちがこの技術と向き合う上で最も重要な出発点となります。

AIが心を理解できない未熟な存在だからこそ、私たちはその判断を鵜呑みにせず、常に批判的な視点を持つ必要があります。AIに組み込まれたバイアスを見抜き、その限界を認識し、責任の所在を明確にしなければなりません。

AIが心を理解できない冷徹な計算機だからこそ、私たちはその能力が悪用されたときの恐ろしさを直視しなければなりません。感情データのプライバシーを守り、感情操作という見えざる脅威から個人の自由と尊厳を守るためのルールを、今こそ構築しなければなりません。

そして何より、AIが心を持たないからこそ、私たちは人間が持つ「心」の価値を再認識することができます。非効率で、矛盾に満ち、時には傷つけ合う不完全な存在。しかし、だからこそ他者の痛みに「共感」し、論理を超えた「直感」で判断し、不条理な世界に「意味」を見出そうとする。この人間特有の心の働きこそが、AIには決して代替できない、私たちの最後の砦なのかもしれません。

AIと心が交差する未来は、バラ色のユートピアでも、暗黒のディストピアでもなく、その両方の可能性をはらんだ、複雑で挑戦的な世界です。その舵取りは、AIに任せることはできません。

この技術をどう使い、どう制御し、どう共存していくのか。

その選択は、この記事を読んでいる、私たち一人ひとりの双肩にかかっているのです。

・日々の悩みを心理AIに話してみませんか→ 【Awarefy】

・ 国内最大級のオンラインカウンセリングサービス【Kimochi】

コメント